Les Transformers & HuggingFace

Published:

HuggingFace rend l’IA accessible à tous grâce à sa librairie Transformers et à son écosystème riche. Découvrons ensemble ses concepts clés et ses usages pratiques.

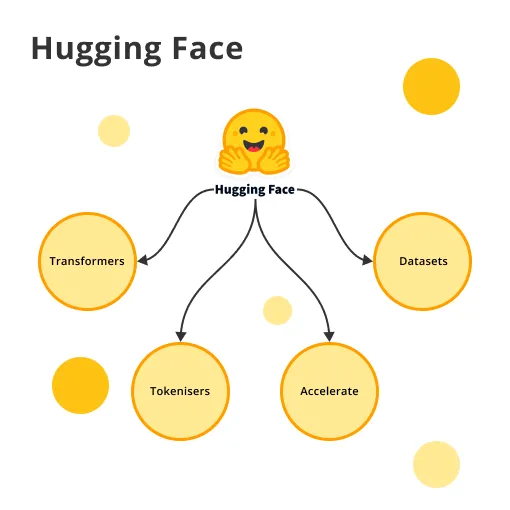

1. Introduction à Hugging Face

Hugging Face est une plateforme incontournable pour les passionnés d’intelligence artificielle. Elle est à la fois une communauté et une plateforme pour la recherche et l’utilisation de modèles de grande taille. Sa librairie open-source transformers permet de travailler facilement avec des modèles de traitement du langage naturel (NLP), de vision par ordinateur, l’audio et bien plus encore. Grâce à des modèles pré-entraînés, vous pouvez rapidement intégrer des fonctionnalités avancées dans vos applications Python.

Hugging Face démocratise l’accès aux modèles d’intelligence artificielle de dernière génération en proposant une interface unifiée pour PyTorch, TensorFlow et JAX. Grâce à cette approche, les technologies avancées de machine learning deviennent utilisables par tous, des chercheurs chevronnés aux développeurs débutants.

L’entreprise a récemment enrichi son écosystème avec les Inference Endpoints, un service d’IA clé en main spécialement conçu pour répondre aux exigences des organisations professionnelles. Cette innovation représente la réponse de HuggingFace au défi majeur de l’industrialisation des modèles d’apprentissage automatique. Elle transforme ce qui nécessitait auparavant plusieurs semaines d’efforts techniques complexes en un processus fluide permettant de créer une API fonctionnelle en quelques clics seulement.

2. Les Transformers avec Hugging Face

Les Transformers représentent une avancée majeure dans le domaine de l’intelligence artificielle, révolutionnant notre capacité à traiter et comprendre les données textuelles, visuelles et audio. Hugging Face a démocratisé l’accès à ces modèles complexes grâce à une plateforme intuitive et des outils puissants adaptés à tous les niveaux d’expertise.

Les pipelines : une porte d’entrée simplifiée

La bibliothèque Transformers propose des pipelines, véritables abstractions de haut niveau qui permettent d’utiliser des modèles sophistiqués en quelques lignes de code seulement. Cette approche prêt à l’emploi couvre plus de 30 tâches courantes comme la classification de texte, la reconnaissance d’entités nommées, la génération de texte ou la réponse à des questions.

from transformers import pipeline

# Classification de sentiment

sentiment = pipeline("sentiment-analysis")

result = sentiment("L'écosystème Hugging Face est remarquablement bien conçu !")

print(result)

# Génération de texte

generator = pipeline("text-generation")

print(generator("Hugging Face permet aux développeurs de", max_length=30)[0]['generated_text'])

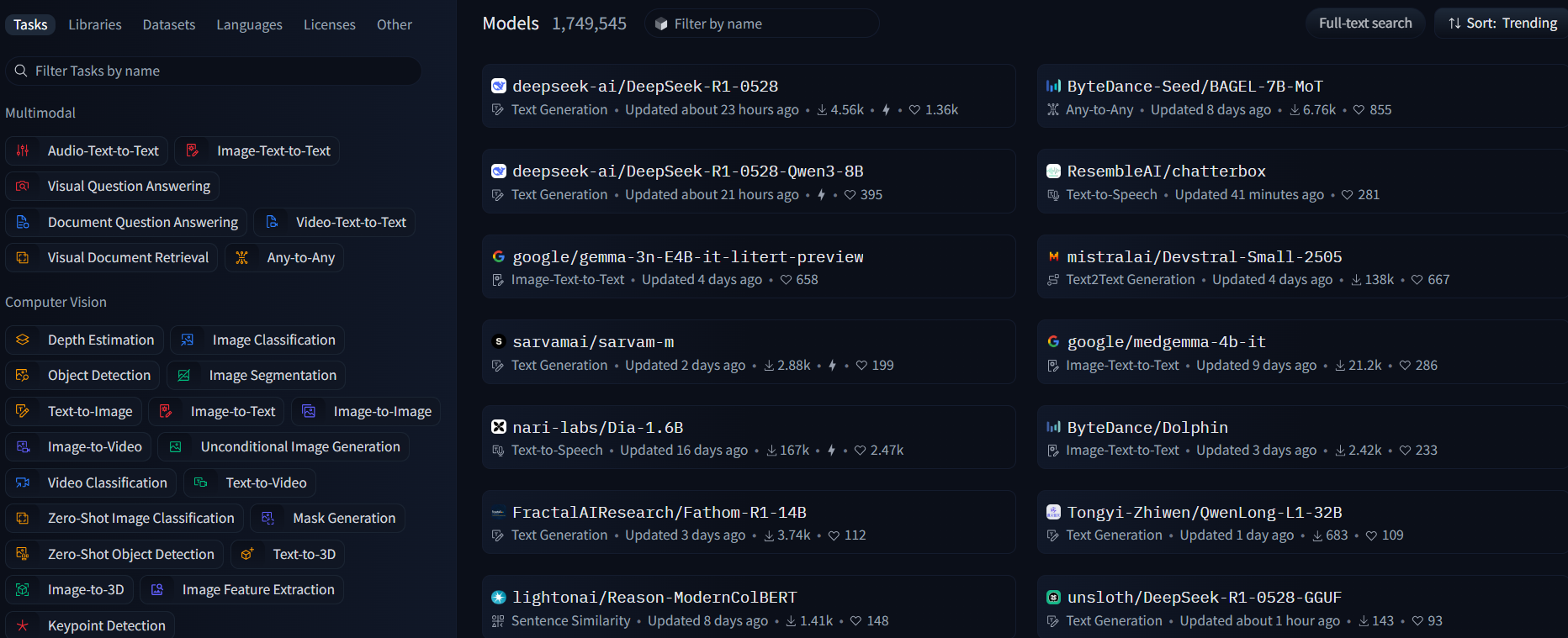

L’écosystème complet : bien plus qu’une bibliothèque

La plateforme Hugging Face s’articule autour de quatre composants fondamentaux qui forment un écosystème complet :

Le Hub : Une plateforme collaborative hébergeant plus de 150 000 modèles pré-entraînés, 20 000 datasets et des milliers d’espaces de démonstration. Cette véritable bibliothèque mondiale de l’IA permet de télécharger, partager et collaborer sur des ressources de haute qualité.

Les Auto-Classes : Un système intelligent qui sélectionne automatiquement l’architecture appropriée en fonction du checkpoint choisi. Cette abstraction élégante simplifie considérablement le code et rend les modèles interchangeables.

from transformers import AutoModel, AutoTokenizer

# Chargement automatique de l'architecture correcte pour BERT

model = AutoModel.from_pretrained("bert-base-uncased")

tokenizer = AutoTokenizer.from_pretrained("bert-base-uncased")

# Traitement d'un texte

inputs = tokenizer("Hello Hugging Face!", return_tensors="pt")

outputs = model(**inputs)

Les Datasets : Une bibliothèque dédiée pour charger, préparer et manipuler facilement des jeux de données variés, avec des fonctionnalités avancées comme le streaming pour les données volumineuses.

Les Spaces : Un environnement pour créer et partager des démos interactives de vos modèles, rendant l’IA plus accessible et transparente.

Architecture flexible et interopérable

La force de l’écosystème Hugging Face réside dans son interopérabilité exceptionnelle. Les modèles fonctionnent indifféremment avec les principaux frameworks de deep learning : PyTorch, TensorFlow et JAX. Cette flexibilité permet aux chercheurs et développeurs de travailler dans leur environnement préféré tout en bénéficiant de l’ensemble des fonctionnalités offertes.

Le design modulaire de la bibliothèque sépare clairement les différentes composantes (tokenizers, modèles, configurations) tout en maintenant une cohérence d’ensemble. Cette architecture permet une utilisation intuitive des modèles complexes tout en offrant la possibilité de personnaliser chaque élément pour les utilisateurs avancés.

# Exemple avancé : utilisation personnalisée d'un tokenizer et d'un modèle

from transformers import BertModel, BertTokenizer

import torch

# Chargement spécifique

tokenizer = BertTokenizer.from_pretrained("bert-base-uncased")

model = BertModel.from_pretrained("bert-base-uncased")

# Préparation des entrées

text = "Hugging Face transforme l'accès aux technologies d'IA."

encoded_input = tokenizer(text, padding=True, truncation=True, return_tensors="pt")

# Extraction des embeddings avec gradient désactivé

with torch.no_grad():

output = model(**encoded_input)

# Récupération de l'embedding de la phrase (du token [CLS])

sentence_embedding = output.last_hidden_state[:, 0, :]

print(f"Dimension de l'embedding: {sentence_embedding.shape}")

Ce code illustre comment Hugging Face permet de charger et d’utiliser des modèles de manière flexible, tout en offrant des fonctionnalités avancées pour les utilisateurs expérimentés.

Pour aller plus loin

Explorez HuggingFace.co !